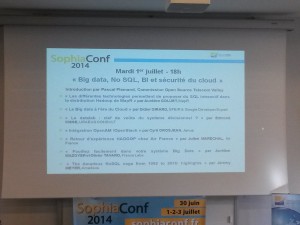

Il y a cinq ans j’assistais à la 1ère Sophia Conf 2010, cette fois c’est la 5ème itération de la conférence qui a eu lieu sur 4 jours du 30 juin au 3 juillet 2014. J’ai participé cette fois à la journée consacrée au Big Data et NoSQL. Pas moins de 7 intervenants ont présenté leur retour d’expérience sur ces technologies.

Les 4 interventions qui m’ont marqué le plus étaient tout d’abord celle sur MapR par Aurélien Goujet. En effet, MapR est une distribution pour Hadoop qui embarque de nombreuses optimisations et drivers extrêmement performants qui ont nécessité 2 ans de développement. MapR a fait le choix de développer par exemple des drivers IO écrits en C pour augmenter drastiquement les performances des process MapReduce. Les benchmarks qui comparent MapR aux autres distributions comme Cloudera CDH ou Hortnworks HDP parlent d’elles-mêmes.

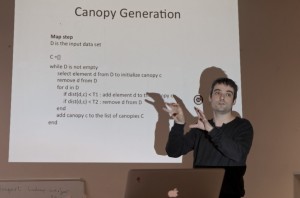

Ensuite, j’ai apprécié la présentation sur le Big Data avec Google Cloud Platform par Didier Girard de la société SFEIR. Didier nous a présenté comment l’utilisation de briques très performantes du Google Cloud Platform peuvent être utilisées ensemble pour créer des application Big Data facilement. Une des applications présentées illustre une utilisation pratique de Compute Engine, BigQuery et App Engine.

Ensuite Julien Maréchal nous a présenté un retour d’expérience sur l’implémentation et l’utilisation de Hadoop chez Air France. La partie intéressante pour moi était comment l’infrastructure Hadoop a pu être intégrée dans le système existant de Air France. Un des objectifs d’avoir installé Hadoop à Air France est la mise a disposition pour l’entreprise d’une structure pour le calcul parallèle.

Enfin Jeremy Meyer a présenté l’utilisation de NoSQL chez Amadeus. La présentation a commencé avec une partie “histoire” du NoSQL chez Amadeus, mais ayant déjà personnellement travaillé chez Amadeus dans 5 équipes et 2 départements différents, je connaissais déjà bien cette partie. Ensuite, Jeremy nous a présenté le choix des solutions actuelles, et pourquoi il a été orienté sur les solutions Couchbase, Memcached et MongoDB. Il n’a pas manqué aussi de nous expliquer comment ces solutions ont été intégrées dans l’architecture informatique Amadeus car certaines parties ont dû être développées pour lier les éléments entre eux, et comment ils ont travaillé en étroite collaboration avec les équipes de Couchbase pour rendre le driver IO de Couchbase multi-threaded.

Voila au final la journée était une réussite, la majorité des sujets étaient bien présentés d’une façon claire et agréable à suivre. On se rend compte comment le Big Data prend chaque année une place de plus en plus importante dans les structures et comment la variété des solutions montrent une maturation grandissante du domaine.